UniFi UNAS Pro 8: Erfahrungen, fehlende Features und Wünsche

Ich habe es getan. Für unser Büro war ich auf der Suche nach einem simplen NAS, welches als File-Server für Proxmox-VMs und andere Clients dienen kann. In diesem Artikel will ich meine Erfahrungen teilen und einige Baustellen dokumentieren.

Das Wichtigste vorab: Das hier wird kein Testbericht und ich werde auch keine Worte über die technischen Daten und allgemeinen Funktionen des UNAS Pro 8 verlieren. Dafür gibt es bereits gute Berichte und YouTube ist gefühlt voll mit Feature-Auflistungen.

Ich möchte hier für euch (und für mich) dokumentieren, womit ich beim Umstieg auf das UNAS gekämpft habe (und kämpfe). Ich hoffe, ich komme regelmäßig dazu, diesen Artikel zu aktualisieren. Falls nicht, seht es einfach als historische Dokumentation, was das UNAS Pro 8 einmal war. 😉 Auf geht’s!

Fürs Protokoll: UNAS Pro 8 Version 4.4.11 und UniFi Drive 3.4.1. Stand: 05.12.2025

Das UNAS Pro 8 ist groß (zu groß?) und hat keinen Powerbutton

Im Netz an einigen Stellen bereits angesprochen: Das UNAS Pro 8 ist ganze 48 cm tief. Das ist für die allermeisten „normalen“ Serverschränkchen deutlich zu viel. Zu beachten ist: die Länge muss ab der vorderen Rackschiene des Racks gemessen werden. Zur Rückwand braucht ihr dann noch mal locker 5 cm Puffer, um Kaltgerätestecker und SFP+-Kabel oder Ethernet anzustecken. Auch diese Stecker brauchen Platz.

In unser Rack hat es gerade so hereingepasst. Nach hinten ist es Millimeterarbeit. Natürlich passten die mitgelieferten Rackschienen nicht mehr. Dafür braucht man noch mal locker 10 cm mehr Platz.

Und damit komme ich auch zu einem ersten Problem in meiner Situation: Das UNAS Pro 8 startet automatisch, wenn es mit dem Stromnetz verbunden wird. Alles gut. Jetzt ist alles schön im Rack verbaut und ich musste das Gerät herunterfahren – nicht darüber nachgedacht. Die Kiste ist aus. Tja, und jetzt?! Da das NAS direkt mit einem Ausgang an der USV verbunden ist (nicht einzeln schaltbar), sah ich mich schon kurz davor, das ganze Geraffel wieder auszubauen.

Zum Glück war genau ein Millimeter genügend Platz nach hinten, um den Kaltgerätestecker leicht zu lösen, sodass das Netzteil kurz die Spannungsversorgung verloren hat und beim nächsten Kontakt wieder ansprang. Wer den Netzstecker besser zugänglich hat, hat das Problem natürlich nicht.

Vielleicht übersehe ich hier irgendwas. Bin für jeden Hinweis dankbar.

Die Festplattenkäfige lassen sich nicht abschließen

Ich hab’ gedacht: Okay, beim bisherigen NAS von QNAP waren die HDD-Käfige immer brav abgeschlossen, um dumme Unfälle auszuschließen (man weiß ja nie). Das UNAS Pro 8 hat keinen solchen Schließmechanismus. War jetzt auf meiner Must-Have-Liste zugegebenermaßen auch nicht ganz oben, sodass ich drüber hinweggesehen habe.

Was soll ich sagen: Die Käfige des UNAS Pro 8 springen zu leicht auf. Das Ganze ist so ein Push-Open-System, wie bei hochwertigen Küchenschubladen. Wenn man doof gegenkommt, springt einem die Tür von einem der Käfige schnell entgegen.

Das einzig Gute: Die HDD wird dabei nicht direkt vom NAS getrennt. Dafür muss man den Käfig schon bewusst herausziehen. Hat trotzdem bereits mindestens zwei Mal für einen Schreckmoment gesorgt.

Ansonsten ist die Hardware (also das Gehäuse) des Gerätes wirklich wunderbar verarbeitet und auch das Einsetzen der rückseitigen SSDs in die (leider optionalen M.2-Trays) ist wirklich gut gemacht, UniFi-typisch halt.

Eine (lange) Reise durch die RAID-Modi

Bedauerlicherweise war es mir nicht vergönnt, zu dem NAS auch neue Platten zu beschaffen und so direkt mit einem vollbestückten UNAS Pro 8 zu starten. Stattdessen stand eine Migration von einem anderen 8-Bay-QNAP-NAS mit 8 x 18 TB auf das UNAS Pro 8 an. Die Daten wurden dafür auf verschiedene andere Datenträger zwischengespeichert (keine Angst, Backups, auch Offsite sind vorhanden – sonst sollte man bei diesem Spiel nicht mitspielen).

Ich bin also mit einer Ausstattung von 1x 16 TB (als Puffer) und 8x 18 TB (aus dem alten NAS gestartet). Mein Vorgehen war sicher nicht optimal, aber ich habe versucht, das Ganze mit verfügbarem HDD-Material über die Bühne zu bringen.

Der Weg führte also über einen Storagepool im UNAS Pro 8, der immer wieder erweitert worden ist. Interessant ist dabei, dass das UniFi NAS immer erst ein „Minimal Raid Array“ baut und dann andere Platten in einem zweiten Schritt erweitert. Was bedeutet das? Ganz einfach: Die ganze Nummer dauert lange.

Beispiel: Ich bin mit einem Storagepool mit dem Ziel eines Raid 6 gestartet. Zunächst hatte dieser Pool 1 HDD. Im nächsten Schritt wurden zwei weitere HDDs eingesetzt (jetzt also insgesamt 3). Das UNAS Pro 8 hat dann zunächst ein Raid 1 gebaut und die übrige Platte als Hotspare behandelt. Nach dem Raid 1 Build folgte dann der Raid 5 Build. Jeder dieser Prozesse dauert mindestens 2 Tage.

Okay, dann lief das Raid 5 Array mit 3 Platten. Als Nächstes wurden die übrigen 5 Platten eingesetzt und dem Storage Pool zur Verfügung gestellt (jetzt also 8 HDDs). Wieder ging es los mit einem Upgrade auf Raid 6. Wieder wurde aber nur eines der fünf zusätzlichen Laufwerke in einem Zwischenschritt verwendet, bis ein Array mit vier HDDs im Raid 6 lief. Erst danach erfolgte die Erweiterung des Raid 6 auf alle 8 HDDs.

Fair enough: Nicht der Musterweg. Aber „logistisch“ ging es nicht anders. Das Ergebnis: Knapp zwei Wochen Raid-Builds am Stück in irgendeiner Form. Zum Glück stecken dort Exos X18 drin, die das hoffentlich aushalten. 😀

Was lernt ihr daraus? Wer einen ähnlichen Weg gehen muss, sollte die „Zwischen-Builds“ zeitlich einplanen. Viel Spaß!

UniFi Drive vergisst Speichererweiterung des Storagepools

Update: Ich habe für meinen Fall herausgefunden, was hier los ist. Und zwar hatte ich dem Storagepool bereits im Status Raid 5 (siehe oben) einen Raid 1 SSD-Cache zugewiesen. Das ist auch das gesamte Problem: LVM-Volumes die gechached sind, können nicht so einfach in der Größe verändert werden. Also habe ich mir ein Herz gefasst und den SSD-Read/Write-Cache in UniFi Drive noch einmal gelöscht. *Magie passiert*: Zwei Sekunden später ist das logische Volume automatisch in der Größe angepasst – ohne irgendwelche Spielereien via SSH. Das bedeutet: Prüft, ob ihr einen SSD-Cache aktiviert habt, wenn ihr in dieses Problem lauft. Falls ja: Ausschalten, kurz abwarten, wieder einschalten. Fertig.

So wunderbar, das Array ist endlich da, wo es sein soll. Doch wo ist eigentlich die ganze zusätzliche Speicherkapazität geblieben?

Beim Wechsel von 1x HDD (Raid Nix) auf 3x HDD (Raid 5) wurde die Kapazität des Storagepools direkt an die neue Kapazität der Raid Group (so nennt UniFi das Array) angepasst. Dann den gleichen Spaß (wie oben zu lesen) noch mal von 3x HDD (Raid 5) auf 8x HDD (Raid 6) gemacht. Die Raid-Gruppe wurde auch fein auf die neue Kapazität aktualisiert.

Leider lief im Hintergrund wohl irgendwas nicht richtig. Jetzt hing mein Storagepool weiterhin bei der Kapazität aus der 3x HDD (Raid 5)-Situation, während meine Raid 6 Group bereits die volle Kapazität anzeigte. Das Problem ist offenbar schon länger bekannt (Link1, Link 2, Link 3) und hätte (laut dem, was ich gelesen habe, wohl bereits mit Firmware 4.4 behoben sein sollen), tja.

Die Ursache ist offenbar, dass das System das physische Volume (repräsentiert durch die Raid Group) korrekt erweitert hat. Die Erweiterung des logischen Volumes wurde aber vergessen / ausgelassen (?).

In einem der Links ist dafür auch ein Fix beschrieben, der bei mir funktioniert hat.

Ausrückliche Warnung: Wer hier per SSH in der Volume-Struktur rumhantiert, sollte wissen, was er tut. Datenverlust ist sehr gut möglich, wenn ihr hier Mist baut! Funktionierendes (!!!) Backup ist also Pflicht. Genauso wie die „Lust“ das ganze Raid noch mal zu bauen. Ihr handelt auf eigene Verantwortung und Gefahr!

Wichtig: Alle Laufwerksbezeichnungen und IDs können (und werden) bei euch anders sein! Nicht einfach Befehle kopieren und danach traurig sein!!!

Schritt 1: Zunächst muss der SSH-Zugang über die Console-Einstellung des UNAS Pro 8 aktiviert werden. Danach per SSH auf das NAS verbinden. (Ich beschreibe hier mal nicht, wie das geht, als ersten Fail-Safe für Personen, die davon gar keine Ahnung haben und damit auf dem besten Weg sind, ihr Array zu himmeln. :D)

Schritt 2: Die aktuelle Volumestruktur auslesen mit

df -hSchritt 3: Die ID der betroffenen Raid Group herausfinden. Dazu kann die Kapazität hilfreich sein, falls ihr mehrere Arrays habt. Sieht dann ähnlich aus wie, das hier:

Filesystem Size Used Avail Use% Mounted on

/dev/mapper/vge9b1abd8-lv9d43bec9 30T 27T 2.2T 93% /volume/d752e9dd-810b-42e2-9058-ad5e93121de2Hier werden in meinem Fall noch 30 TB angezeigt, obwohl ich 108 TB erwartet hätte.

Schritt 4: Prüfen, ob das physische Volume korrekt erweitert ist:

cd /dev/

lsHier solltet ihr die Geräte „md3“, „md4“, etc finden. Bei mir ist „md3“ meine Raid Group und „md4“ ist der SSD-Cache-Pool. Wenn ihr noch mehr Storagepools (respektive Raid Groups) angelegt habt, kann es hier weitere Geräte geben.

Mit folgendem Befehl können wir uns die Eigenschaften der physischen Volumes ansehen:

pvdisplay /dev/md3Wenn hier unter „PV Size“ die Kapazität auftaucht, die erwartet wird, dann ist auf der Ebene schon einmal alles fein. Es sollte sich hierbei um etwa denselben Wert handeln, wie er in UniFi Drive für die Raid Group angezeigt wird.

Schritt 5: Raid Group-Kapazität erweitern

Weicht der Wert ab (ist das physische Volume also zu klein), kann es mit folgendem Befehl auf den maximal verfügbaren Speicherplatz erweitert werden:

sudo pvresize /dev/md3 --verboseHinweis: „–verbose“ gibt detaillierter zurück, was die Kiste treibt.

Wenn das erledigt ist, sollte der Wert nun der erwarteten Kapazität entsprechen. Denkt dran: Hier wird in TiB und nicht in TB (bzw. GiB und nicht in GB) gerechnet.

Schritt 6: Logisches Volume erweitern

Jetzt müssen wir noch die Kapazität des logischen Volumes (Storagepools) erweitern. Das war ja mein ursprüngliches Problem.

Dazu benötigen wir den File-System-Pfad aus der Abfrage aus Schritt 3. Kann sein, dass der Mount-Point auch gehen würde – habe ich nicht probiert. Der Befehl lautet dann:

lvextend -l +100%FREE /dev/mapper/vge9b1abd8-lv9d43bec9Achtung: Die ID (hier vge9b1abd8-lv9d43bec9) muss angepasst werden!!!

Tipp: Sollte jetzt der Fehler „Unable to resize logical volumes of cache type.“ erscheinen, schaut mal oben in die grüne Update-Box. 😉

Schritt 7: Fertig und Überprüfen

Ihr könnt jetzt mit dem folgenden Befehl noch einmal prüfen, ob der Storagepool nun richtig angepasst wurde (wieder nach der ID Ausschau halten):

df -hDas war’s. Volle Kapazität da. Danke, UniFi, dass das so einfach ist. 😛

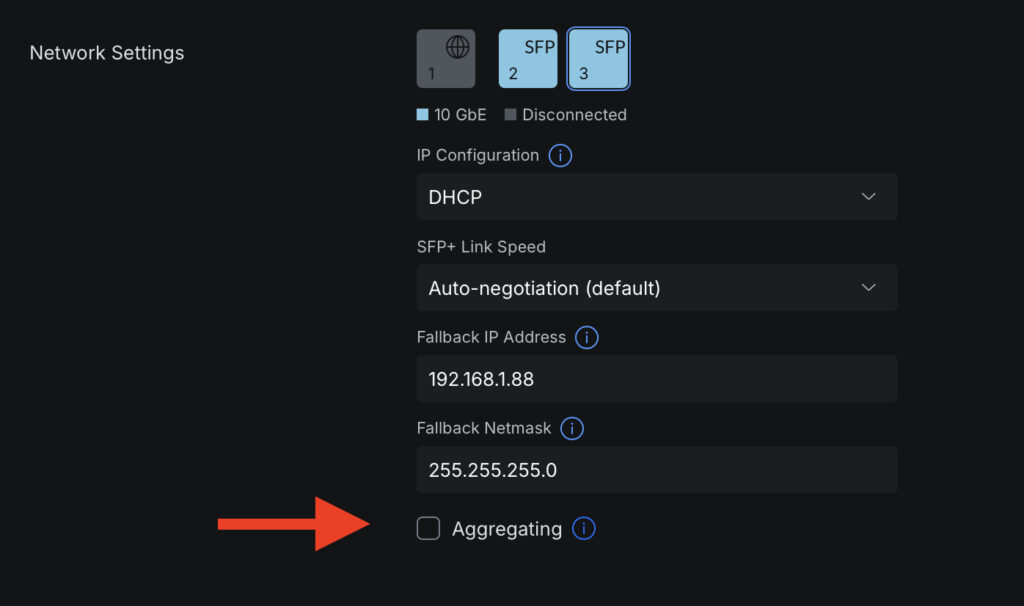

Link Aggregation: Die Checkbox fehlt

Eigentlich wollte ich das UNAS Pro 8 gerne per Link Aggregation über 2x SFP+ an den vorhandenen UniFi Switch Aggregation anschließen. Das ist mir bis heute nicht geglückt. (Siehe auch Link 1)

Angeblich soll beim Verbinden des zweiten SFP+-Links in den Console-Einstellungen eine Check-Box auftauchen, die die Konfiguration von Link Aggregation ermöglicht. Ist bei mir nicht der Fall. Stattdessen bezieht das NAS zwei IP-Adressen per DHCP und verwirrt sich damit selbst.

Update: Nach der Aktualisierung auf Firmware 4.4.11 respektive Drive Version 3.3.10 ist die Checkbox für Aggregation jetzt auch bei mir sichtbar und funktioniert.

SSD-S.M.A.R.T-Analyse fantasiert und killt Read/Write-Cache-Volume

Mal wieder was Neues: Eine der Cache-SSDs ist laut dem UNAS Pro 8 fehlerhaft (auf Basis der SMART-Werte). Leider verrät das NAS nicht, was genau nicht mehr stimmt. Die Konsequenz: Der SSD-Cache fällt auf Read-Only zurück, weil es das RAID-1-Cache-Volume zerlegt. Das NAS nimmt das „defekte“ Laufwerk also automatisch außer Betrieb, was eigentlich gut ist.

Das Problem: Der SSD geht’s eigentlich gut. Nach einem Neustart sieht das UNAS das genauso und akzeptiert die SSD wieder, sodass sich ein neues RAID-1-Cache-Volume erstellen lässt. Bisschen lästig, aber immerhin gehen dabei keine Daten verloren – ist ja „nur“ Cache.

Schön wäre, wenn Unifi hier alle SMART-Werte im Storage-Manager einfach anzeigen würde. Dann bräuchte man das Laufwerk nicht auszubauen, um es extern mit einem vernünftigen Tool zu überprüfen (ich wollte keine extra Software per SSH auf dem UNAS selbst installieren).

Was UniFi Drive unbedingt noch braucht

Hier noch ein paar Dinge, die aktuell ein wenig stören und die UniFi ganz leicht aus der Welt schaffen könnte.

Keine anständigen Fortschrittsanzeigen

Wenn man etwas kopiert, verschiebt oder löscht, was nicht innerhalb von wenigen Sekunden erledigt ist, taucht das Ganze am unteren Rand und in der rechten Seitenleiste als „Systemtask“ auf.

Schöner Kringel der sich dreht. Man hat bloß leider keine Ahnung, was die Kiste tut. Kein Fortschrittsbalken (in %) oder vielleicht sogar eine Transfergeschwindigkeit! Das sind wirklich Grundlagen (immerhin ist UniFi Drive nun auch schon 1+ Jahr auf dem Markt).

Keine anständigen Ordnerdetails

Derzeit scheint es keine Möglichkeit zu geben, Details für einzelne Ordner innerhalb eines Shared Drives anzuzeigen. Mit Details meine ich Dinge, wie Anzahl Dateien, Azahl der Unterordner und natürlich die Gesamtdateigröße des Ordners.

Workaround: Per Windows oder Mac über SMB gehen, dauert aber lange und ist unkomfortabel.

Keine schöne Live-Throughput-Anzeige

Das UNAS Pro 8 zeigt zwar irgendwelche lustigen Werte für den Speicherdurchsatz an (mit SSD-Cache sind diese häufig hoch und dann wieder lange bei 0 MB/s). Ich würde mir hier ein paar Statistiken wünschen, was der SSD-Cache treibt, was das HDD-Array treibt und am wichtigsten: eine schöne Echtzeitanzeige des Netzwerkdurchsatzes. Auf der Dream Machine SE haben sie das so super gelöst (für WAN-Auslastung). So etwas muss doch für das UNAS Pro 8 auch möglich sein?

Ich bin das von QNAP gewohnt. Das ist nämlich ein einfacher Weg, um zu schauen, ob gerade überhaupt irgendwas passiert.

Backup-Dienst braucht eine FTP oder WebDAV-Option

Ich weiß gar nicht, ob es in die Backup-Sektion passt. Was ich noch vermisse: Das UNAS Pro 8 ist aktuell per SMB/CFIS oder NFS ein „doofes“ Storage-Target. Das soll es auch sein. Ich würde bloß gerne eine Option sehen, um Daten von anderen (Web-)Servern per SFTP oder WebDAV) AUF das UNAS zu sichern. Das UNAS Pro 8 soll also als Client und nicht als Server fungieren und sich die Daten holen.

Vielleicht ist das aber auch schon wieder „zu viel“ Serverfeature für eine reine Speicherkiste? Praktisch wäre es trotzdem. Ich weiß, man kann QNAPs nicht mit dem UniFi-Gerät vergleichen, aber ein paar Funktionen aus der QNAP HBS-Anwendung wären schon praktisch.

War’s das schon?

Für den Moment schon.

Abseits der kleinen Themen von oben läuft das UNAS Pro 8 unauffällig und stabil. Es ist ausreichend schnell und auch die Backup-Jobs und Snapshots laufen zuverlässig. Wenn mir noch etwas auffällt, werde ich versuchen, die Liste zu ergänzen.

Sollten sich Themen über neue Updates in der Zukunft erledigen, seht es mir nach, wenn die Punkte hier (ggf.) immer noch stehen, und seht es einfach als historische Dokumentation an, was das UNAS Pro 8 mal für Probleme hatte und wie weit es mittlerweile gekommen ist. 😉

Happy NASing!